Google Analytics es una herramienta excelente, pero no es perfecta. En MD la utilizamos todos los días, y por eso decidimos traducir el siguiente análisis que hizo Tom Capper para Search Engine Land sobre los vacíos de datos en Analytics. Aquí, la segunda parte sobre los filtros y el Google Tag Manager versus on-page.

Razón 3: los filtros de Analytics

Es un poco obvio, pero los filtros que hayas configurado en tu Analytics pueden reducir intencionalmente (o no) los niveles de tráfico informados.

Por ejemplo, un filtro que excluya ciertas resoluciones de pantalla de nicho que creas (quizás sin suficiente razones) que son principalmente bots o tráfico interno. Estos casos, obviamente, causarán que tu configuración no sea reportada correctamente.

Impacto de pérdida de datos por filtros: ¿?

El impacto es difícil de estimar: la configuración obviamente variará sitio por sitio. Recomendamos tener una vista “maestra” duplicada y sin filtrar en caso de que te des cuenta demasiado tarde de que has perdido algo que no pretendías perder.

Razón 4: GTM vs. on-page vs. on-page mal implementados

Google Tag Manager se ha convertido en una forma cada vez más popular de implementar análisis en los últimos años, debido a su gran flexibilidad y la facilidad para realizar cambios. Sin embargo, hemos notado desde hace tiempo que puede teneder a informar menos configuraciones on-page.

También teníamos curiosidad sobre lo que sucedería si no siguieramos las directrices de Google al configurar el código en la página.

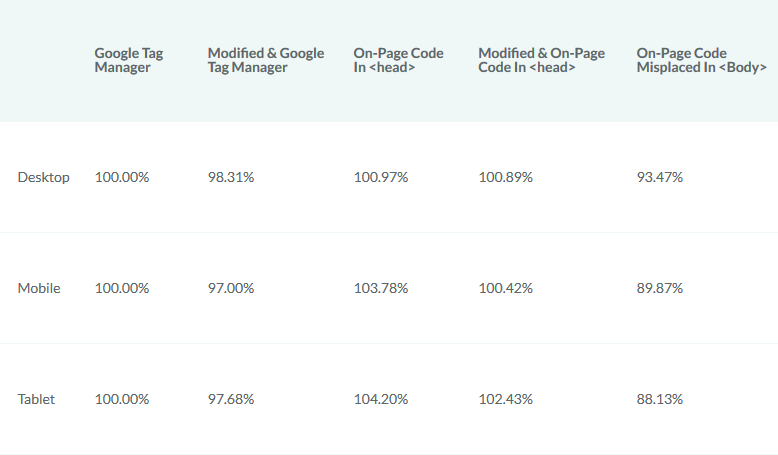

Al combinar nuestros números con los números del sitio de un colega que usa un add-on de Drupal y GTM, pudimos ver la diferencia entre Google Tag Manager y un código on-page mal implementado (justo en la parte inferior de la etiqueta <body>). Ponderamos esto con nuestros propios datos de Google Tag Manager para obtener una imagen general de las 5 configuraciones.

Efecto de GTM y códigos on-page mal implementados

El tráfico como porcentaje de la línea de base (implementación estándar de Google Tag Manager):

Hay algunos puntos principales aquí:

Vale la pena señalar también que las implementaciones personalizadas realmente obtuvieron menos tráfico que las implementadas. Para el código on-page, esto está dentro del margen de error, pero para GTM hay otra razón (porque usamos perfiles no filtrados para la comparación, hay mucho spam de bots en el perfil principal, que principalmente se enmascara como Internet Explorer.

También dividimos los datos por dispositivos:

Al parecer los navegadores móviles, como Internet Explorer, pueden tener dificultades con Google Tag Manager.

Datos perdidos por GTM: 1-5%

En el sitio de nuestro colega, el impacto del código mal implementado fue de alrededor del 7,5% vs. el GTM. Teniendo en cuenta que el GTM mismo presenta informes erroneos, la pérdida total podría estar fácilmente dentro del 10%.

Bonus: datos perdidos de canales

Nos hemos enfocado en áreas donde es posible que falten datos por completo. Sin embargo, también hay muchas formas en que los datos pueden tergiversarse, o pueden faltar detalles. El principal problema es el tráfico oscuro.

Tráfico oscuro

El tráfico oscuro es el tráfico directo que realmente no vino vía directa (y que se está volviendo cada vez más común). Las causas típicas son:

- Campañas de mail sin etiquetas.

- Campañas en aplicaciones sin etiquetas (especialmente Facebook, Twitter, etc.)

- Orgánica mal representada.

- Datos enviados desde implementaciones de seguimiento fallidas (que también pueden aparecer como self-referrals)

También vale la pena señalar la tendencia hacia el tráfico genuinamente directo que, históricamente, habría sido orgánico. Por ejemplo, debido a las autocompletadas de navegador cada vez más sofisticadas, a la historia de varios dispositivos, etc., la gente termina “escribiendo” una URL que históricamente habrían buscado.

Fuente: Search Engine Land

Traducción: Manuel Tacconi

Deje su comentario